14.Dropout

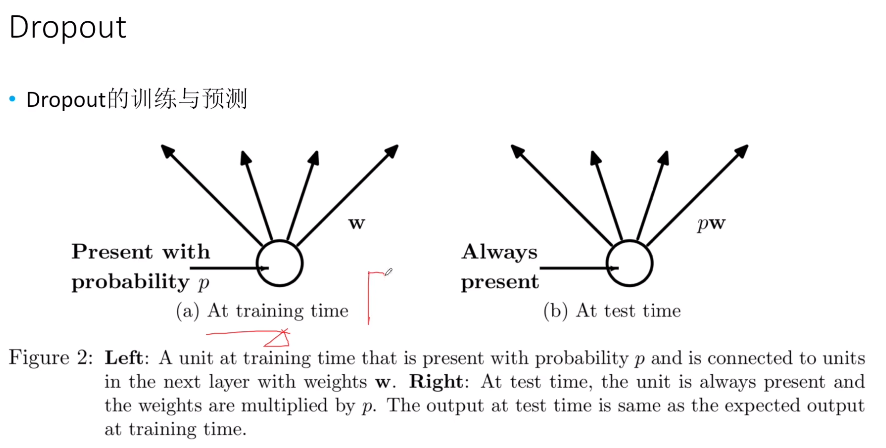

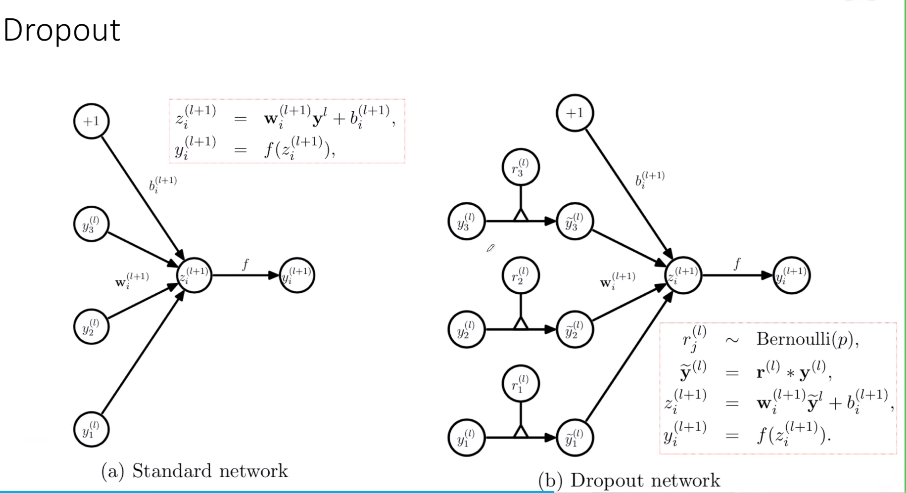

在训练过程中,dropout会以概率p随机地将一些神经元的输出设置为0,防止过拟合。在测试过程中,dropout不会被应用,而是通过将每个神经元的输出乘以保留概率(通常为0.5)来进行缩放。这是因为测试时,我们希望利用所有的神经元来获得更好的预测结果。

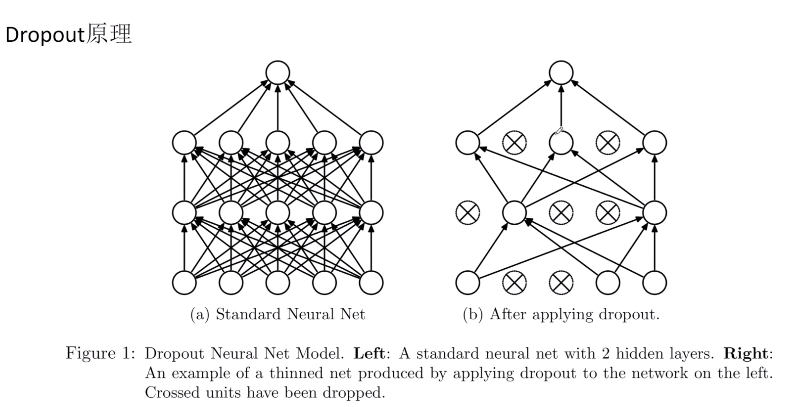

dropout的工作原理是,在每个训练批次中,随机选择一些神经元,并将它们的输出设置为0。这样做的结果是,网络不再依赖于特定的神经元,而是强迫网络学习多个独立的特征子集,从而减少了过拟合的风险。

1 | torch.nn.Dropout(p=0.5, inplace=False) |

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 咋的个人博客!